Si le changement a toujours été le seul fait perdurable du secteur informatique depuis des années, le rythme de celui-ci s’est aujourd’hui accéléré. Savoir accompagner la transformation de l’IT est ainsi devenu un enjeu stratégique pour la performance de l’entreprise.

Souvenez-vous, le neuralyzer est ce petit appareil utilisé par les agents J et Q de Men in Black (MIB) pour effacer la mémoire du public mis en relation avec des extraterrestres ou témoins d’un phénomène prouvant leur existence. Partons de ce postulat, oublions tous les concepts actuels et débutons une feuille blanche.

Il est aujourd’hui révolu le temps ou les utilisateurs se contentaient d’exploiter des applications et des ressources fournies par le département informatique. Les dynamiques de marché et les récentes avancées technologiques ont en effet fondamentalement changé leurs attentes. Ils étaient auparavant de simples consommateurs et deviennent aujourd’hui de véritables consommacteurs. Les utilisateurs privés maîtrisent parfaitement les réponses qui satisferont avec justesse leurs besoins. Ils sont connectés au quotidien avec l’informatique (consultation de leurs emails, de leurs comptes bancaires, de l’actualité ou encore tweets,…).

Si à titre personnel le  niveau de service qui leur est proposé est de haut niveau, en entreprise, ce niveau est loin d’être à la hauteur de ce qu’ils attendent (interfaces conviviales, possibilité d’accéder à leurs applications et données partout et à tout moment, proposition de solutions innovantes pour résoudre des problématiques actuelles et ou de longues dates.).

niveau de service qui leur est proposé est de haut niveau, en entreprise, ce niveau est loin d’être à la hauteur de ce qu’ils attendent (interfaces conviviales, possibilité d’accéder à leurs applications et données partout et à tout moment, proposition de solutions innovantes pour résoudre des problématiques actuelles et ou de longues dates.).

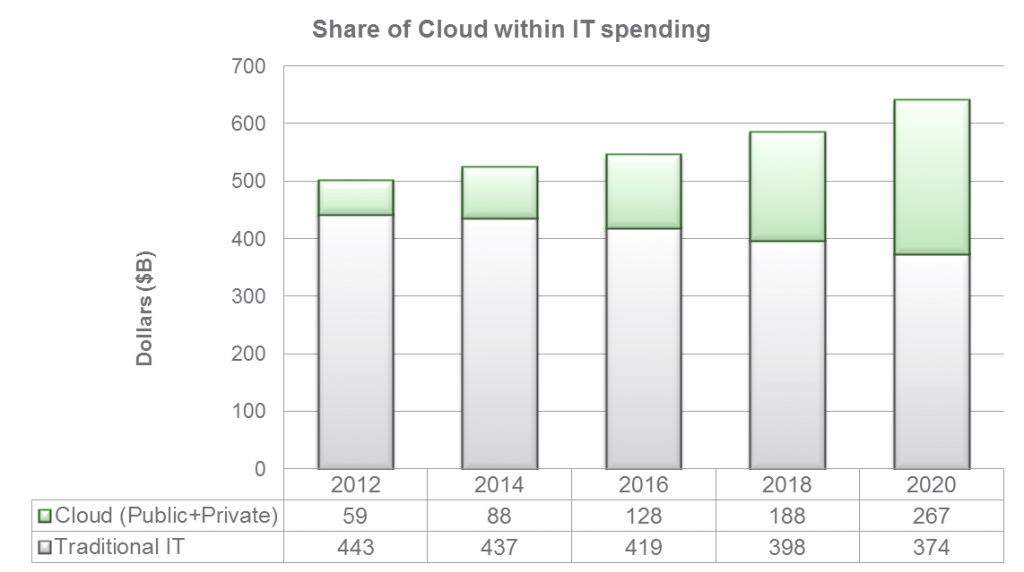

Le Cloud est le facteur clé de croissance

De plus, grâce à leur facilité d’accès, ces technologies sont accessibles à tous. Rien de plus simple que de télécharger une application mobile ou d’ouvrir un compte utilisateur gratuit (ou à faible coût) auprès d’un fournisseur de services de Cloud Computing pour travailler plus efficacement. L’utilisateur se procure ses propres technologies, pour un usage professionnel ou privé, et devient alors consommateur de Cloud pour répondre à ses propres désirs et consomme seulement ce qu’il utilise.

Les fournisseurs externes sont ainsi devenus de véritables précurseurs et concurrents en apportant aux utilisateurs un niveau de service que les départements informatiques ne sont jamais parvenus à atteindre pour cause de leur fonctionnement en silos. Quel utilisateur serait assez patient pour attendre des jours de la part de son département informatique l’obtention d’une ou plusieurs applications de gestion de projets ? Il préfèrera les tester lui-même directement en ligne sans perdre de temps, et exploitera ainsi le Cloud public au détriment de sa DSI.

Les fournisseurs externes sont ainsi devenus de véritables précurseurs et concurrents en apportant aux utilisateurs un niveau de service que les départements informatiques ne sont jamais parvenus à atteindre pour cause de leur fonctionnement en silos. Quel utilisateur serait assez patient pour attendre des jours de la part de son département informatique l’obtention d’une ou plusieurs applications de gestion de projets ? Il préfèrera les tester lui-même directement en ligne sans perdre de temps, et exploitera ainsi le Cloud public au détriment de sa DSI.

Le marché de l’informatique traditionnel décroit, on peut soit simplement regarder ce marché mourir à petit feu, soit être pro-actif par l’accompagnement de la transformation de l’IT.

Ces analyses et réflexions démontrent que l’IT doit fondamentalement être transformé en profondeur pour devenir un fournisseur de services auprès de ses différents métiers.

Chaque ligne métier a en effet besoin d’innover pour être compétitive sur son marché et souhaite par conséquent accéder au Cloud pour y parvenir. Cependant, des contraintes persistent : les départements informatiques doivent composer avec un socle existant et des applications développées en interne. Les pressions financières, l’insuffisance de ressources et donc de temps sont aussi des facteurs ne permettant pas aux DSI d’être accompagnées sur cette transition et/ou ces changements.

Alors, comment procéder ?

Les DSI doivent au préalable procéder à une cartographie applicative (c’est-à dire évaluer si toutes les demandes d’évolution passent bien par elles) et s’assurer ensuite qu’elles apportent le bon niveau de service.

Un questionnement précis s’impose alors aux responsables IT :

- Avons-nous la capacité de répondre à la demande (ressources, compétences)?

- Existe-t-il des services ou une gestion des processus?

- Quelle est la tendance pour une forte hausse ou baisse de l’activité?

- A quoi les lignes métiers n’auraient-elles pas songées?

- Quel est le niveau d’industrialisation de la maintenance applicative?

- Quels sont les efforts (le coût) concernant la migration vers le Cloud?

- Quel est le volume de données stockées?

- Quel est le volume de données à transférer?

- Que vont devenir les actifs existants?

Tant d’interrogations qui nous emmènent à la réflexion suivante : en quoi cette transformation va-t-elle consister ?

Réponse : en l’adoption du Cloud par l’informatique.

Dans les faits, les entreprises n’ont pas à renoncer à leur contrôle. Elles peuvent au contraire proposer une large gamme d’options de fourniture de services, comprenant Clouds publics, privés et hybrides. Les départements informatiques se tournent actuellement de plus en plus vers ces solutions afin d’assurer la flexibilité et l’efficacité demandées par leurs utilisateurs tout en préservant la visibilité et le contrôle dont ils ont besoin.

S’il est important d’automatiser le provisionnement initial, il est tout aussi important d’automatiser le processus de fourniture de services de bout en bout.

Comment y parvenir ?

Une des bases de cette transformation fut l’adoption de la virtualisation des serveurs, permettant ainsi de rationaliser et de consolider les charges de travail.

Nous estimons qu’entre 70 et 80 % des charges de travail sont aujourd’hui virtualisées. Or, dans un data center, les serveurs ne sont pas les seuls à pouvoir être virtualisés, reste de nombreuses autres composantes tels que le stockage, la sécurité, ou encore les technologies de réseau,etc.

Et si nous décidions ainsi d’appliquer le principe de la virtualisation abstraction, pool et automatisation à l’ensemble du data center afin d’amener l’IT a plus de performance, de flexibilité et d’adaptation aux besoins des utilisateurs ?

Il deviendrait alors primordial d’automatiser et d’orchestrer toutes les couches du data center.

Cette démarche permet ainsi d’obtenir une conception du data center défini par logiciel : le SDDC (Software-Defined DataCenter). Cette architecture est idéale pour la construction et l’exploitation d’un cloud privé, hybride ou cloud public.

L’architecture SDDC virtualise tous les domaines du data center : calcul de stockage et de disponibilité, réseau et sécurité, et offre une gestion automatisée par logiciel.

L’architecture SDDC repose sur quatre éléments principaux en virtualisant l’intégrité des ressources de calcul du data center.

Sa finalité première est d’ériger le département informatique en tant que fournisseur de services pour tous les métiers de l’entreprise, autrement dit d’amener un modèle organisationnel et fonctionnel de type IT-as-a-Service (ITaaS).

Pour accéder à ce modèle, plusieurs étapes sont nécessaires :

Étape 1 : virtualiser les services réseau et sécurité puis les mettre à la disposition de la couche de calcul selon un modèle de consommation à la demande => Software Defined Network (SDN). Exemple VM-1000-HV de Palo Alto Networks, ou Trend Micro avec Deep Security, etc…

Étape 2 : Dupliquer cette étape 1 pour le stockage et ainsi extraire, regrouper, et automatiser un stockage local et externe hétérogène de façon à créer un système de fichier distribué => Software Defined Storage (SDS).

Pour la partie stockage ou SDS, voici quelques exemples de solutions offrant ce type de modèle : Nexenta, ViPR de EMC², VSAN de VMware,etc.

Pour la partie stockage ou SDS, voici quelques exemples de solutions offrant ce type de modèle : Nexenta, ViPR de EMC², VSAN de VMware,etc.

En résumé, le SDS et le SDN consistent principalement à dissocier les logiciels du matériel sous-jacent pour améliorer l’efficacité informatique.

On extrait l’intelligence du hardware pour la positionner dans le software.

Tous les services étant ainsi virtualisés, vous pouvez désormais pousser l’utilisation des ressources et l’automatisation beaucoup plus loin qu’auparavant.

Pour obtenir ce résultat, les équipes d’infrastructure peuvent aussi s’appuyer sur des infrastructures dites « convergées » ou CI (Converged Infrastructure) qui sont de plus en plus matures. Je citerais quelques exemples: VBLOCK de VCE, Flexpod de chez NetApp & Cisco, et plus récemment nous avons vu arriver sur le marché des solutions « hyperconvergées », comme VxRail de Dell EMC, Nutanix, ou Simplivity , apportant une autre philosophie autour du stockage distribué.

|

A partir de là, cette nouvelle architecture proposera des pools de ressources de calcul, de stockage et de réseau qui seront allouées dynamiquement aux applications et services.

Étape 3: Cette phase consistera à repenser en profondeur les processus métier. Pour s’assurer d’un projet Cloud, le département informatique devra impérativement collaborer avec les process owners. La transformation des process devra passer par l’automatisation et le self-service de ces derniers, et se devra d’adopter un modèle de re-facturation basé sur la consommation.

Étape 4: Redéfinir la sécurité, souvent considérée comme le frein au passage vers le Cloud (encore plus marqué après l’épisode « Prisme« ). Concernant cet aspect très sensible, 3 critères devront être étudiés:

- La gestion des identités (fédération des identités)= Qui accède?

- La gestion des accès = Comment et à quoi? (exemple: NetIQ Access Manager)

- Contrôle de continu (supervision sécurité, et gestion des logs, exemple: RSA Security Analytics).

L’architecture Cloud offre une grande liberté de choix. Elle est compatible avec la majorité des matériels et apporte toute la flexibilité requise pour s’ajuster de façon dynamique aux besoins liés à l’activité.

L’architecture Cloud offre une grande liberté de choix. Elle est compatible avec la majorité des matériels et apporte toute la flexibilité requise pour s’ajuster de façon dynamique aux besoins liés à l’activité.

Une telle approche induit des progrès spectaculaires en termes de réactivité, d’efficacité de contrôle et de liberté de choix pour le département informatique et pour le reste de l’entreprise.

Excellent article Noham.

Merci Francis pour ce retour, j’avoue avoir passé un peu de tps à la rédaction, même si je ne vais pas en profondeur, je souhaitais dresser un portrait de ce que j’ai pu voir en prod du côté des équipes infra.

[…] de la transformation des entreprises (un discours concordant avec mon article publié récemment Pourquoi conduire la transformation de l’IT est aujourd’hui un incontournable ?. A travers leurs discours, les dirigeants VMware en ont aussi profité pour nous faire partager […]

[…] de demain (Containers/Dockers). Quand et qui sera le premier à proposer la première solution « SDDC all in a box » capable de répondre à tous ces […]

[…] reprendre et donner une prolongation à l’article de Noham « Pourquoi conduire la transformation de l’IT est aujourd’hui un incontourable ? » : Il y a quelques temps les fournisseurs externes arrivaient à être plus précurseurs que […]

Très intéressant merci Noham !