Le SDS de A à Z Le logiciel est partout. Serveur, stockage ou réseau, il n’existe plus un pan de l’infrastructure qui ne soit passé par la case « software-defined », au point que l’on parle aujourd’hui de « software-defined datacenter », voire même de « software-designed everything ». Mais toutes les couches du centre de données défini par logiciel n’en sont pas au même point. …

SDS

Acheter la convergence aujourd’hui pour respirer le futur

Par Emmanuel Forgues Acheter la convergence (VCE, VMware, EMC) ou l’Hyper-convergence (VCE, Nutanix, Simplivity, Atlantis) aujourd’hui pour respirer le futur Délivrer l’IaaS comme fondation de l’ITaaS Pour reprendre et donner une prolongation à l’article de Noham « Pourquoi conduire la transformation de l’IT est aujourd’hui un incontourable ? » : Il y a quelques temps les fournisseurs externes arrivaient à être plus précurseurs …

Atlantis USX – Storage is Software

Atlantis USX – The New Order of Storage Freedom Atlantis est une solution purement Software, elle fournit une solution de stockage par logiciel (100%), du pur SDS ! Atlantis USX Unified Software-Defined Storage est une solution intelligente de stockage définie par logiciel. Elle peut fournir instantanément des ressources de stockage pour toute application utilisant plus efficacement une infrastructure classique existante et permet de renforcer …

Hyper-Convergence – le nouveau visage du Datacenter

L’hyper-convergence : un buzz ? un phénomène de mode ? L’hyper-convergence est-elle en train de modifier le paysage de nos Data centers et de nos salles informatique ? Intéressons nous à une technologie qui n’a pas fini de faire parler d’elle … Mais c’est quoi l’Hyper-convergence ? L’Hyper-convergence est une architecture basée sur le logiciel qui s’intègre étroitement avec les ressources de …

Episode I : Le logiciel englouti le monde du stockage !

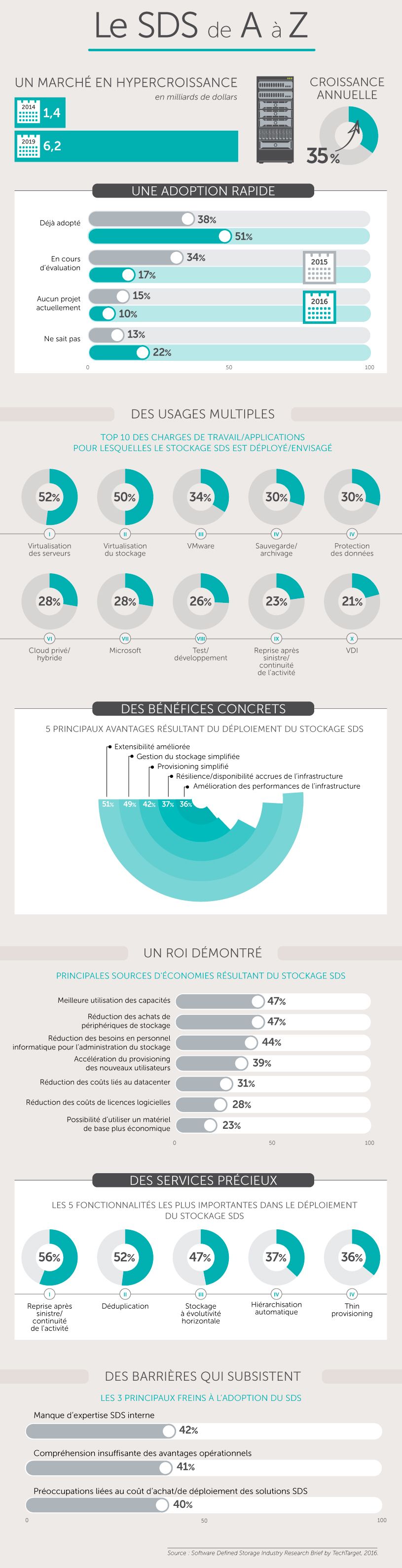

Dossier SDS Software-Defined Storage Retrouvez dans l’édition N°50° de l’E.D.I , un dossier complet sur le Software-Defined Storage, cette nouvelle approche du stockage qui offre une flexibilité autour du stockage et met l’accent sur celle-ci plus que sur la partie hardware. L’objectif est bien de fournir aux équipes d’exploitation et d’administration des fonctionnalités souples de gestion par le biais de …

VMware Partner Exchange 2015 – Dare To Thrive

La grande conférence annuelle de VMware Partner Exchange vient de se clôturer à San Francisco au Moscone Center : état des lieux Dare : to have enough courage or confidence to do something To thrive : to prosper: be fortunate or successful Our Must wins in 2015 Le Partner Exchange c’est aujourd’hui plus de 4000 partenaires et 80 nationalités représentées et rassemblées …

ViPR – Software Defined Storage par EMC²

Retrouvez mon article sur ViPR dans le monde informatique EMC ViPR transforme un environnement de stockage physique hétérogène en une solution simple, extensible et ouverte, vers une plateforme de stockage virtuelle. « ViPR, la solution de stockage pilotée par le logiciel » Interview de Noham Medyouni, Solutions Architect Specialist chez SCC Comment s’inscrit l’offre ViPR dans la stratégie …

VMworld 2014 Day 3

General session : Keynote introduite par Carl Eschenback et Ben Fathi (CTO) Day 3 – 15 octobre 2014 Mercredi 15 octobre à Barcelone, la keynote d’ouverture est introduite par Carl Eschenbach (Président & Chief Operating Office). A travers son discours, Carl a principalement rappelé les impacts positifs d’une architecture basée sur du Software-Defined et a notamment insisté sur l’importance de …

Pourquoi conduire la transformation de l’IT est aujourd’hui un incontournable ?

Si le changement a toujours été le seul fait perdurable du secteur informatique depuis des années, le rythme de celui-ci s’est aujourd’hui accéléré. Savoir accompagner la transformation de l’IT est ainsi devenu un enjeu stratégique pour la performance de l’entreprise. Souvenez-vous, le neuralyzer est ce petit appareil utilisé par les agents J et Q de Men in Black (MIB) pour …

VSI 6.x EMC² pour le client Web vSphere

VSI : Virtual Storage Integrator Ce plug-in fournit par EMC permet d’offrir un accès facile à partir de l’interface du client Web vSphere 5.5 afin de provisionner des datastores en VMFS et NFS. Le plug-in est téléchargeable à l’adresse suivante, la version 6.2 est disponible depuis le 10 Juillet 2014: https://support.emc.com/products/34010_VSI-for-VMware-vSphere-Web-Client VSI assure une intégration et un approvisionnement de VMware vCenter …