Pour conclure cette fin d’année 2013, je souhaite partager avec vous ma vision propective de la transformation de l’IT au travers du SDDC.

SDDC : Software Definied DataCenter

Depuis 2008, les DSI sont soumises à de fortes pressions économiques. Les budgets alloués à l’informatique régressent de manière significative et les exigences en terme de retour sur investissement marquent un tournant pour le secteur. La nécessité de réduire les coûts est devenue une préoccupation majeure pour les DSI.

Depuis 2008, les DSI sont soumises à de fortes pressions économiques. Les budgets alloués à l’informatique régressent de manière significative et les exigences en terme de retour sur investissement marquent un tournant pour le secteur. La nécessité de réduire les coûts est devenue une préoccupation majeure pour les DSI.

Nous sommes aujourd’hui très loin du temps ou de nombreux DSI disposaient d’une forte latitude pour investir massivement. L’heure est à la centralisation des données ; non seulement pour faire des économies de serveur ou de stockage mais également pour avoir comme objectif d’accroître la performance du système d’information.

Si l’avènement de la virtualisation couplée à une baisse significative des coûts des composants informatiques a contribué à une réduction notoire des dépenses, le retour sur investissement demeure aux yeux de beaucoup insuffisant face aux résultats escomptés.Force est de constater que ce ne sera ni sur le matériel, ni sur la géolocalisation du Datacenter et encore moins sur le modèle en silos de l’informatique que des économies de budget pourront être réalisées ; mais bien sur une nouvelle approche architecturale pour l’infrastructure informatique.Aujourd’hui, les DSI ne savent pas suffisamment tirer profit des équipes d’exploitation ou d’administration. Notamment parce que le temps alloué à des opérations de support ou de maintenance, la validation des infrastructures déployées ou encore le fait d’allouer du stockage, des ressources de calcul, de mémoire en fonction des pré-requis de la MOA lors d’un nouveau projet n’apportent aucune valeur ajoutée à l’entreprise.Il en résulte une sous exploitation et un gâchis des ressources humaines disponibles. De nombreux administrateurs, architectes ou consultants qui officient dans ces entreprises possèdent de vraies compétences et sont souvent reconnus par le biais de travaux transverses et notamment via des blogs qu’ils animent. Il apparaît aussi très clairement que de nombreuses équipes d’infrastructure ne maîtrisent pas suffisamment les ressources que leurs confèrent leurs DataCenter. Il ne s’agit là bien évidemment que d’un constat et nullement d’un jugement ou d’une critique. Cet état de fait se vérifie par la virtualisation à outrance (VM Sprawling). Nous assistons aujourd’hui à un phénomène de prolifération de machines virtuelles, que nous associons systématiquement à du stockage. Il y a quelques années, nous faisions la même remarque concernant les serveurs physiques : 1 serveur sur 6 serait inutilisé dans le monde.

Il apparaît aussi très clairement que de nombreuses équipes d’infrastructure ne maîtrisent pas suffisamment les ressources que leurs confèrent leurs DataCenter. Il ne s’agit là bien évidemment que d’un constat et nullement d’un jugement ou d’une critique. Cet état de fait se vérifie par la virtualisation à outrance (VM Sprawling). Nous assistons aujourd’hui à un phénomène de prolifération de machines virtuelles, que nous associons systématiquement à du stockage. Il y a quelques années, nous faisions la même remarque concernant les serveurs physiques : 1 serveur sur 6 serait inutilisé dans le monde.

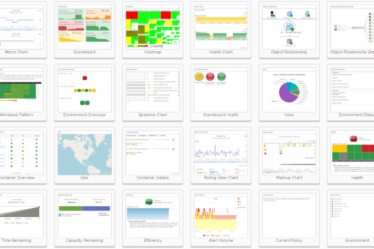

À partir de ce postulat, des solutions de capacity management fleurissent et semblent de plus en plus séduire les DSI.

Autres constats :

Certaines équipes se sont implémentées d’outils d’ordonnancement, ont conçu des scripts, des process, dans le but d’optimiser et d’industrialiser la livraison d’infrastructures. Cette méthode a cependant ses limites. Si elle a permis aux équipes d’infrastructure de les soulager de certaines tâches, elle les oblige alors à maintenir en conditions opérationnelles ces solutions.

Ces différents points révèlent en conclusion que pour livrer ces infrastructures ou un service à ses clients, la DSI se doit de suivre un bon nombre de process et de validation souvent instruites par les équipes de gouvernance qui s’appuient sur des normes informatiques comme ITIL ou TOGAF . L’IT devient alors peu réactif face aux demandes croissantes des métiers.

L’émergence des fournisseurs « Cloud » et la réactivité dont ils font preuve ont aussi attiré de nombreux utilisateurs sur le principe « pay as you use », leur permettant par la même occasion de s’affranchir de nombreuses contraintes. Un nouveau terme vient d’apparaître pour caractériser ce phénomène : « Shadow IT ». Il ne faut pas perdre de vue que c’est essentiellement le métier qui amène des projets informatiques. Si l’informatique interne ne propose pas de service réactif et adapté face aux demandes croissantes des utilisateurs, ces mêmes utilisateurs se tourneront très facilement vers des Cloud Providers ou Cloud Public.

L’émergence des fournisseurs « Cloud » et la réactivité dont ils font preuve ont aussi attiré de nombreux utilisateurs sur le principe « pay as you use », leur permettant par la même occasion de s’affranchir de nombreuses contraintes. Un nouveau terme vient d’apparaître pour caractériser ce phénomène : « Shadow IT ». Il ne faut pas perdre de vue que c’est essentiellement le métier qui amène des projets informatiques. Si l’informatique interne ne propose pas de service réactif et adapté face aux demandes croissantes des utilisateurs, ces mêmes utilisateurs se tourneront très facilement vers des Cloud Providers ou Cloud Public.

Afin d’éviter cette fuite en avant, un nouveau concept est apparu. Si hier ce concept n’était que marketing (introduit par Steve Herrod CTO VMware lors du VMworld 2012), aujourd’hui il s’avère incontournable aux DSI : le Software Definied DataCenter ou le SDDC.

Afin d’éviter cette fuite en avant, un nouveau concept est apparu. Si hier ce concept n’était que marketing (introduit par Steve Herrod CTO VMware lors du VMworld 2012), aujourd’hui il s’avère incontournable aux DSI : le Software Definied DataCenter ou le SDDC.

Afin d’accompagner la métamorphose de l’informatique traditionnelle, les DSI doivent revoir leur stratégie d’infrastructure globale et effectuer la transition depuis un modèle de fourniture de services manuels orienté informatique vers un nouveau modèle ITaaS (IT-as-a-Service) davantage orienté utilisateur.

Aide à la décision

![]()

Il me semble indispensable que cet informatique acquière dans un premier temps des outils de Capacity Management (Know & Decide ou SanSentinel), sache identifier les ressources allouées et par qui et dans un second temps, inclut dans ce process une notion de re-facturation pour sensibiliser et éduquer les métiers aux coûts inhérents à leur demande.

Il me semble indispensable que cet informatique acquière dans un premier temps des outils de Capacity Management (Know & Decide ou SanSentinel), sache identifier les ressources allouées et par qui et dans un second temps, inclut dans ce process une notion de re-facturation pour sensibiliser et éduquer les métiers aux coûts inhérents à leur demande.

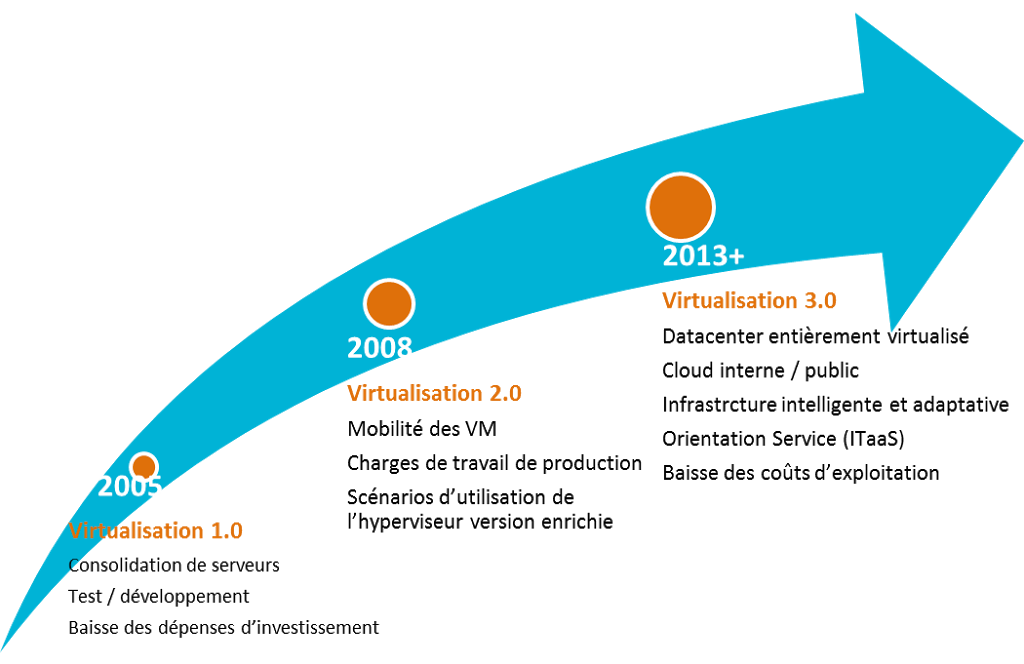

Le SDDC n’est finalement que l’évolution de l’informatique qui s’est opérée avec l’avènement de la virtualisation.

Avec l’évolution de la virtualisation depuis 15 ans, trois grandes phases se sont succédées :

2005 : virtualisation des serveurs des équipes de développement, serveur de test.

2008 : virtualisation des serveurs dits critiques (messagerie, base de données, etc.), adoption en masse de la virtualisation.

2013 : apparition d’une nouvelle terminologie : le SDDC. Ce sont toutes les ressources du DataCenter qui sont mises en œuvre via des logiciels et sont regroupés en pool pour une allocation centralisée et optimisée des ressources.

|

| La virtualisation des serveurs continue d’évoluer |

Le SDDC :

Le développement de protocoles ouverts facilite le déploiement du modèle SDDC. En effet, le SDDC est défini à partir de standards ouverts qui permettent de contrôler des infrastructures virtualisées en faisant appel à divers fournisseurs respectant tous les mêmes API’s.

Exemples : dans ce modèle SDDC on retrouvera les API’s. OpenStack, un projet open source spécialisé dans le contrôle des pools de ressources (processeurs, connectivité, stockage), les API de connectivité de type OpenFlow. OpenFlow propose un modèle pour le contrôle à distance des commutateurs et des routeurs.

L’architecture SDDC virtualise tous les domaines du Datacenter: calcul, stockage, réseau, sécurité et fournit une gestion automatisée par logiciel.

L’architecture du SDDC permet la transformation de l’informatique et rend cet environnement réactif, efficace et automatisé. Ceci permet de rendre les services applicatifs opérationnels en quelques minutes. Ainsi le SDDC facilite le travail des équipes IT internes qui souhaitent préparer des catalogues de services propres à leurs activités.

La DSI peut ainsi se positionner en tant que fournisseur de service d’où le terme « IT as a service« . Elle est aussi légitime par rapport aux demandes métiers et peut repositionner l’IT au cœur de la demande des utilisateurs.

[…] Fujitsu, Inspur, Net One Systems Co. et Supermicro, elle s’inscrit dans la stratégie du SDDC (Software-Defined Data […]

[…] évoqué dans un précédent article, le SDDC (Software-Defined Data Center) est là pour répondre à ces nouveaux enjeux et satisfaire les […]