Introduction

Virtualisation = latin « virtus », sans effet actuel, ce qui est seulement en puissance.

Par conséquent, le virtuel ne s’oppose pas au réel mais à l’actuel (ce qui existe dans le concret), le réel s’oppose au possible.

« est virtuel ce qui, sans être réel a, avec force et de manière pleinement actuelle (c’est-à-dire non potentielle) les qualités (propriétés, qualia) du réel »

Cette définition ne rend pas complètement compte de ce que nous appelons la virtualisation en informatique.

Apparu sur les systèmes x86 il y a une dizaine d’années, la virtualisation de serveurs est aujourd’hui une solution incontournable, et il ne se passe pas un salon informatique ou dans la presse spécialisés sans que l’on parle de virtualisation. C’est devenu un mot à la mode, la virtualisation est dans toutes les bouches. Cette technologie s’adresse aussi bien aux PME qu’aux grands comptes (CAC40, Services Publics, multinationales). C’est devenu une brique indispensable de l’évolution du Système d’Information.

La virtualisation s’impose comme la pierre angulaire du système d’information.

Au fil du temps le système d’information a gagné en complexité et perdu en efficacité, la virtualisation renverse cette tendance en simplifiant un bon nombre de process et de technologie.

Historique: Contrairement à ce que pensent de nombreuses personnes, la virtualisation n’est pas apparue à la fin des années 90, mais ses débuts remontent aux années 60 sur les plates-formes de superordinateurs (Mainframe) d’IBM, à cette époque les machines virtuelles étaient appelées des pseudo-machines.

Le Mainframe utilisait le programme de contrôle pour allouer les ressources et isoler les différentes instances des partitions les unes des autres.

La version contemporaine du programme de contrôle s’appelle un hyperviseur, sa fonction est de superviser les machines virtuelles qui s’exécutent sur le matériel.

Pour mieux comprendre le concept de la virtualisation, prenons cette analogie à un couple client / Fournisseur. Le fournisseur rend un service que le client consomme.Ici, dans la virtualisation cela consiste à intercaler une couche d’abstraction entre un client et un fournisseur, en ce sens notre fournisseur va proposer des ressources à notre client.

|

|

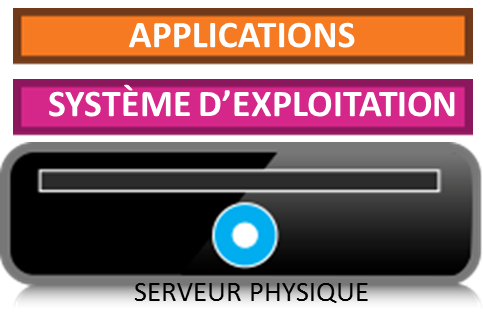

ARCHITECTURE TRADITIONNELLE |

Sans virtualisation, un seul système d’exploitation peut tourner sur une machine physique alors qu’avec la virtualisation il est possible d’en faire tourner plusieurs.

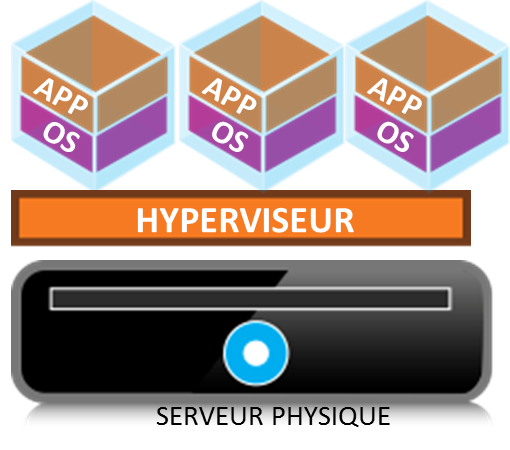

L’hyperviseur rend indépendant un système d’exploitation du matériel sur lequel il est installé et ceci ouvre de grandes possibilités.Cette technologie permet de consolider et de rationaliser les infrastructures serveurs et stockages, elle marque la fin du: 1 Système d’exploitation = 1 machine physique et stockage dédié, avec la virtualisation chaque application et système d’exploitation se trouvent dans une enveloppe générique appelée Machine Virtuelle (VM).

|

| ARCHITECTURE VIRTUELLE |

Les VM sont isolées, les ressources de calcul, les processeurs, le stockage et la mise en réseau sont mis en commun et allouer dynamiquement à chaque VM.

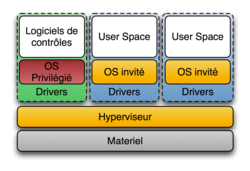

Les différents types d’hyperviseur:

Il existe de 2 types d’hyperviseur en milieu x86:

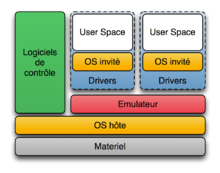

Hyperviseur de type 2:

|

| Source Wikipédia |

c’est un logiciel installé au dessus du système d’exploitation et permet de faire fonctionner plusieurs machines virtuelles. La machine hôte émule la couche matériel pour les OS invités.

Exemples :

•Microsoft VirtualPC ou Virtual Server

•Parallels Desktop

•Oracle VM VirtualBox

•QEMU

•VMware Fusion

A mon avis, l’appellation d’hyperviseur n’est pas adaptée aux solutions de virtualisation s’exécutant au dessus d’un système d’exploitation invité. Je pense que l’appellation « application de virtualisation » est plus appropriée.

|

| Source Wikipédia |

Hyperviseur de type 1

Par défaut c’est un noyau très léger pour gérer les accès des OS invités à l’architecture matérielle. L’hyperviseur présente directement les ressources matérielles aux invités. Cette solution est souvent appelée « bare-metal ».

Exemples:

- Xen

- VMware vSphere

- KVM

- Microsoft Hyper-V Server

Les tendances du marché:

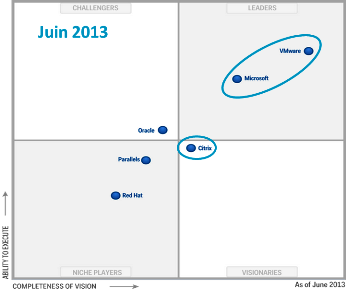

Ci-dessous, vous trouverez les 3 dernières études du Magic Quadrant de Gartner des solutions de virtualisation de serveur x86.

|

| Source Gartner Publication 2011 |

Bien que les offres de Citrix Xen Server et Oracle VM ou Red Hat KVM soient très performantes, le marché s’oriente vers une bataille entre Microsoft et VMware.

VMware domine le marché de la virtualisation et est en avance sur le point technologique par rapport à Microsoft Hyper-V.

|

| Source Gartner Publication 2012 |

VMware est aujourd’hui très implanté dans les grandes entreprises avec une domination quasi-totale.

Microsoft propose hyper-V qui est en 2012 une solution plutôt adaptée pour les PME.

Sur la dernière étude, nous remarquons que le fossé se réduit entre Microsoft et VMware, Citrix fait un pas en arrière dans le Magic Quadrant.

Citrix « laisse » la couche socle de virtualisation pour se concentrer sur les couches hautes à valeur ajoutée (cloud, Mobilité, Desktop…).

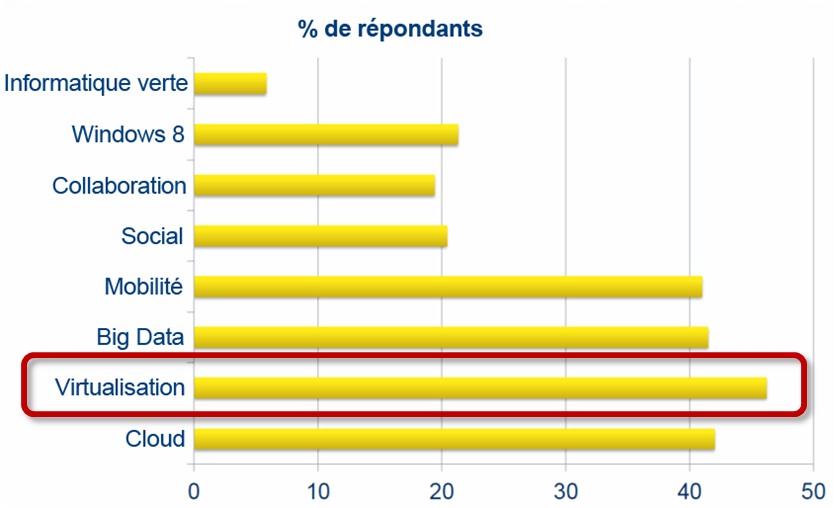

La virtualisation reste la grande priorité en matière de dépenses informatiques.

|

|

Source : rapport IDC State of the Market: IT Spending Review & 2013 Outlook, novembre 2012

|

La croissance de la virtualisation, depuis 2008, où nous avons vu les premiers gros projets de virtualisation fleurirent sur le territoire français, le taux de virtualisation ne cesse d’augmenter. On estime selon une étude menée par VMware qu’en 2015 nous atteindrons entre 75 et 80% des charges de travail virtualisées.

|

|

Source : étude réalisée en janvier 2010, juin 2011 et mars 2012 auprès des clients VMware

|

Pourquoi adopter la virtualisation?

D’après de nombreuses études, il apparaît que 1 serveur sur 6 serait inutilisé dans le monde, et que dans certains Datacenters, l’utilisation des serveurs atteint à peine 5 à 15 %. On peut en déduire que 85 à 95 % des ressources système ne servent à rien et que les salles des serveurs sont encombrées de machines sous-exploitées.

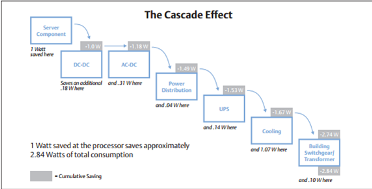

1 Watt économisé au niveau d’un serveur se traduit par 2,84 Watts économisés à l’échelle du Datacenter. C’est ce que l’on appelle l’effet de cascade.

Tout projet de construction de Cloud doit intégrer un volet DCIM (DataCenter Infrastructure Management) car la mutualisation et l’allocation des ressources réclament un contrôle sans faille de l’énergie nécessaire afin de répondre aux demandes pas toujours prévisibles des utilisateurs des applications en mode Cloud.

Avec cette technologie, les bénéfices directs sont indéniables :

la virtualisation fait partie des leviers pour réduire les investissements CAPEX et OPEX, moins de serveurs dans les datacenters = moins d’investissement et donc moins de coût de maintenance, un espace réduit au sol, et une consommation électrique et de climatisation réduite.

Autre exemple, c’est l’amélioration des niveaux de service (SLA), les fonctionnalités de la virtualisation permettent de mettre en place très simplement des solutions de Haute disponibilité, les opérations des sauvegardes sont grandement simplifiées.

Le temps consacré par les administrateurs à des opérations de support ou maintenance qui n’apportent aucune valeur ajouté à l’entreprise est estimé à environ 70%.

Les coûts indirects tels que les coûts de gestion, d’administration et de consommation électrique deviennent astronomique comparés au coût d’acquisition des serveurs et peuvent représenter jusqu’à 4 fois le coût initial du serveur.

La virtualisation apporte l’agilité, une meilleure réactivité et permet de mettre en place des infrastructures dédiées pour un projet sans devoir investir. De plus, les équipes en charge de l’infrastructure se trouvent soulagées par rapport à des tâches récurrentes grâce à l’automatisation et la standardisation, la virtualisation augmente l’efficacité opérationnelle.

machine virtuelle

virtualisation

vps

Je vous remercie de parler de la virtualisation, en particulier à travers l’utilisation de machine virtuelle (https://www.univirtual.ch/fr/business-core/virtualisation-telecommunication/machine-virtuelle), joue un rôle crucial dans le paysage technologique moderne. Elle offre une flexibilité et une efficacité inégalées pour les entreprises en transformant la manière dont les ressources informatiques sont déployées et gérées. En permettant la création de serveurs virtuels multiples sur une seule machine physique, la virtualisation optimise l’utilisation des ressources matérielles tout en offrant une isolation et une sécurité accrues. Les entreprises peuvent provisionner rapidement des environnements de développement, de test et de production selon leurs besoins spécifiques, ce qui accélère les cycles de déploiement et réduit les coûts opérationnels. La virtualisation univirtual permet également une évolutivité dynamique, permettant aux entreprises de faire face à des demandes variables de manière agile, sans compromettre les performances. Cette capacité à ajuster rapidement les ressources informatiques en fonction des besoins fluctuants du marché confère un avantage concurrentiel significatif. De plus, la virtualisation contribue à simplifier la gestion des infrastructures informatiques en consolidant les ressources et en facilitant la migration et la sauvegarde des données. Les vps univirtual et les vm offrent également une plateforme idéale pour le développement et le test de nouvelles applications, permettant aux entreprises d’innover plus rapidement. Donc, la virtualisation est bien plus qu’une simple optimisation des ressources matérielles ; elle représente une évolution majeure dans la manière dont les entreprises déploient et exploitent leurs systèmes informatiques. En adoptant la virtualisation de manière stratégique, les entreprises peuvent réaliser des gains significatifs en termes d’efficacité opérationnelle, de flexibilité et de compétitivité sur le marché.