Ce vendredi 23 février, veille de partir en congé, VMware vient d’annoncer la liste des vExpert pour 2024. Le programme, conçu pour récompenser l’expertise, l’engagement et l’enthousiasme, reconnaît les individus qui contribuent de manière significative à la communauté par le partage de leurs connaissances, de leurs expériences et de leurs meilleures pratiques sur les technologies VMware. Les nominés vExpert de …

vmware

Tanzu: Changement du certificat vCenter

La fin d’année arrive et c’est souvent l’occasion des renouvellements divers et variés.. Nous allons voir un problème qu’on rencontre parfois après avoir renouveler le certificat SSL/TLS d’un vCenter sur des clusters kubernetes Tanzu (ou qui utilise la CPI vCenter !) Aie mon MC : VCenterUnreachable En me connectant sur ma jumpbox pour lancer une mise à jour d’un cluster …

VMware Explore Barcelona 2023 : du Cloud à l’IA, aux Services Souverains

Le VMware Explore Barcelona 2023 est un événement technologique d’envergure où l’avenir du cloud, de l’intelligence artificielle (IA) et des services cloud souverains sont à l’honneur. En réunissant plus de 9 000 participants, et avec plus de 765 sessions de discussion & breakout sessions, le VMware Explore Barcelona 2023 va bien au-delà de l’innovation technologique. C’est une opportunité unique pour …

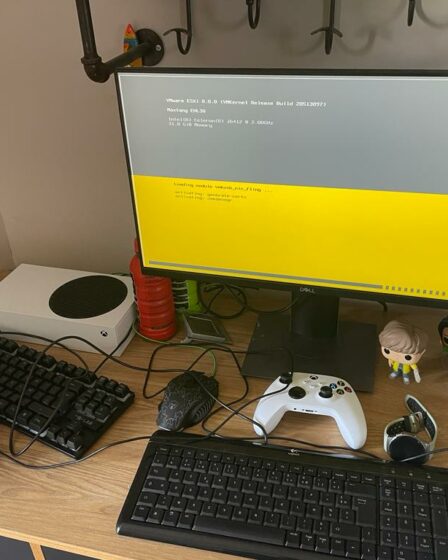

Il était temps !! un mini Lab avec Maxtang NX6412

En 2022, lors du VMware Explore à Barcelone, j’ai eu la chance de recevoir un cadeau incroyable de Cohesity en tant que vExpert : un Maxtang NX6412. Ce PC compact est devenu la base de mon lab VMware, et avec quelques ajouts astucieux… NX6412 – PC Compact Les spécifications de ce boîtier compact sont les suivantes : Le défi avec …

Nomination des vExpert 2023 – France

Cette semaine, VMware vient d’annoncer la liste des vExpert pour 2023. Rappel : Le programme vExpert s’adresse aux personnes ayant contribué de manière significative à la communauté des utilisateurs VMware. Le principe : les candidats au programme vExpert doivent s’engager à partager leur passion et leurs connaissances pour la technologie VMware et pour son écosystème. Les vExperts peuvent s’exprimer au travers de blogs personnels, d’intervention en public (VMUG, …

C’est l’heure de Tanzu (NTP)

Un retour d’expérience concernant la configuration de l’heure dans TKGm (Tanzu Kubernetes Grid Multi Cloud => avec un Management Cluster). En effet, lorsqu’on souhaite renforcer sa configuration, comme toujours la documentation est à lire (RTFM). Le sujet est découpé en 2 articles, un premier sur le partie configuration des serveurs de temps (NTP) et le un second (à paraître) sur …

NSX(-T): Ansible et VM Tag

Lors des projets de segmentation avec NSX, il est très fortement (voir indispensable) d’utiliser les Tags. Malheureusement, il n’est pas possible de récupérer les Tags venant du vCenter. Il peut être intéressant d’automatiser la mise en place de Tag sur NSX en utilisant l’outillage qui réalise déjà la configuration de l’infrastructure à savoir Ansible. VMware met à disposition une …

Le futur se construit avec VMware ARIA

Hello la French VMware communauté, Cela faisait un petit moment que je n’avais pas écrit d’article sur MyVMworld, mais je suis de retour avec de très bonnes nouvelles et aujourd’hui nous allons parler de VMware Aria. Alors beaucoup d’entre vous (clients, partenaires, collègues) me posent souvent la question pourquoi VMware a changé le nom de sa Cloud Management Platform (CMP), …

VMware Explore Day 1 – General Session

Hier était le premier jour du VMware Explore 2022. L’événement a été lancé par la General Session qui est toujours une excellente occasion de s’imprégner de la vision de VMware et de découvrir les annonces phares du géant qui se réinvente en permanence. Une édition européenne reprenant les annonces du VMware Explore US… La session a été introduite par le …

Événement phare de l’année 2022, VMware Explore vient d’ouvrir ses portes !

Un nouveau rendez-vous post-pandémique remplaçant l’ancien « VMworld». Depuis sa scission avec Dell Technologies, VMware était à nouveau devenue une entreprise autonome (Dell avait acquis EMC/VMware pour 67 milliards de dollars en 2015). Une nouvelle ère donc pour VMware et une édition symbole de renouveau après la méga-acquisition de VMware par la société Broadcom. Un événement qui devrait être marqué par les toutes récentes sorties de vSphere 8 …