Un retour rapide sur 2 des différents problèmes rencontrés lors du déploiement de Tanzu Grid Kubernetes (TKGm) sur une infrastructure VMware Cloud Foundation (VCF) avec du NSX Advanced Load Balancer (AVI)

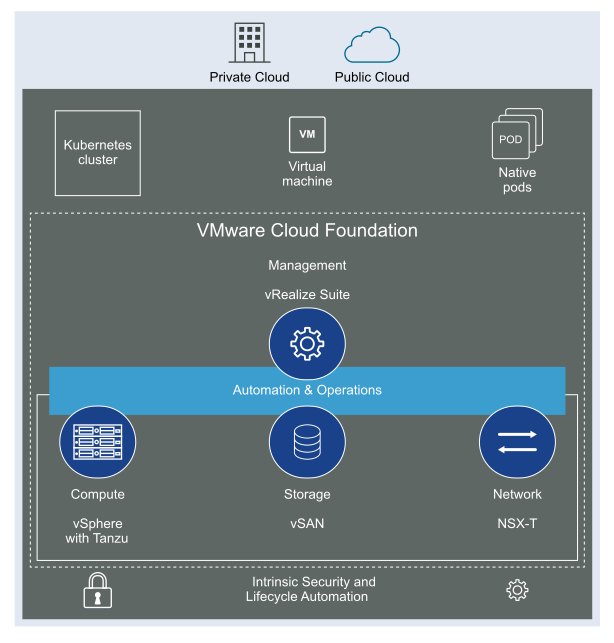

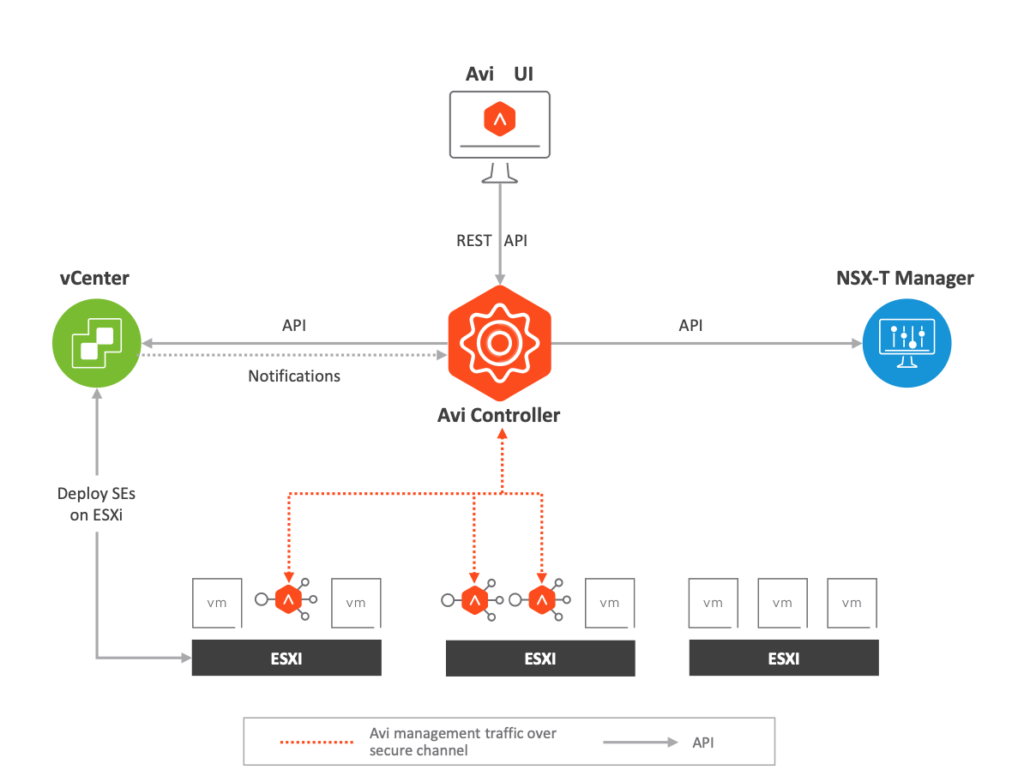

Via VCF, l’infrastructure dispose d’une grande partie de la stack SDDC VMware donc NSX-T pour la sécurité et la virtualisation du réseau.

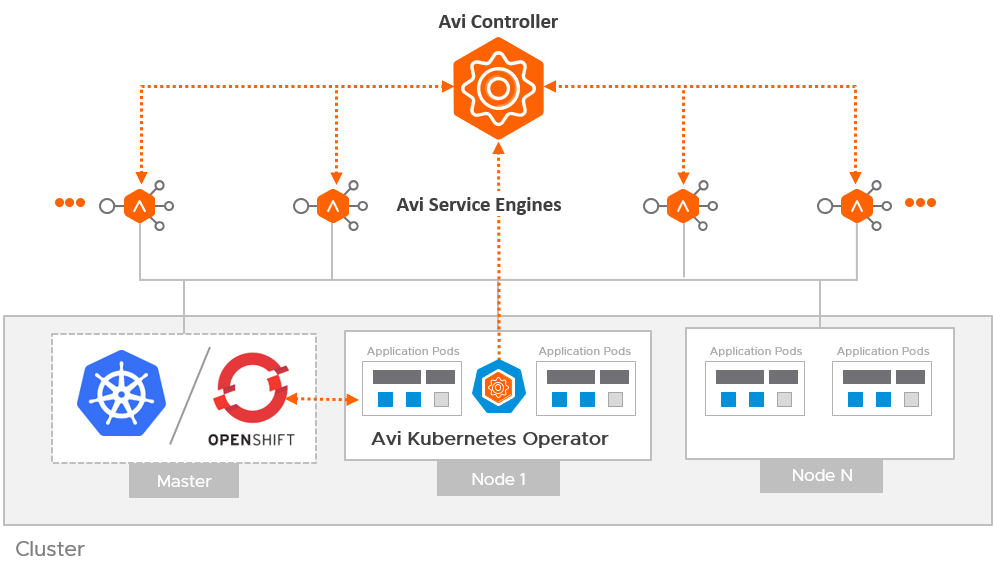

Pour la partie LB, NSX AVI Load Balancer a été choisi pour son intégration Natif avec k8s via AKO.

Premier problème :

Lors du déploiement du management cluster, le pod dédié à ako redémarrais en boucle et était en erreur.

L’erreur était la suivante :

INFO controllers.ConfigMap AVI Client initialized successfully {« ConfigMap »: « tkg-system/avi-k8s-config »}

DPANIC controllers.ConfigMap odd number of arguments passed as key-value pairs for logging {« ConfigMap »: « tkg-system/avi-k8s-config », « ignored key »: « VCF-VDS01-XXXX »}

[…]

Merci à Marie et au forum communities de VMware. En effet, une personne a rencontré le même problème que nous. Et c’est un bug de TKGm 1.5.2 ! Vous avez la possibilité de downgrader en 1.5.1 mais la 1.5.3 est maintenant disponible (attention elle n’est toujours pas recommandée pour la prod à cause d’un problème sur etcd)

Deuxième problème :

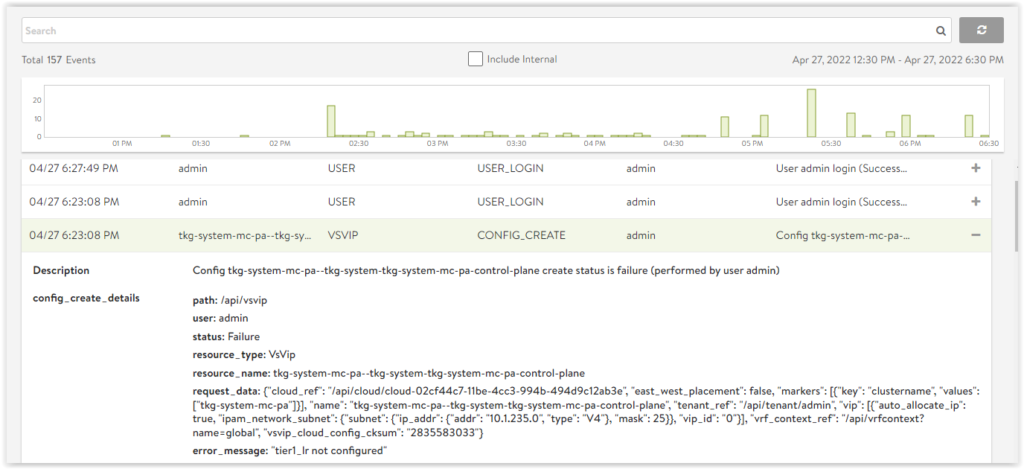

Un peu plus tard, ce problème apparaît lors du déploiement du management cluster et toujours avec la partie intégration AVI / NSX-T.

En effet, AVI pilote directement le NSX-T manager, mais également le vCenter pour le déploiement des Service Engine et enfin des VIP qui sont intégrés comme static route sur les Tier1.

Nous observions l’erreur suivante lors de la création de la VIP sur l’AVI : tier1_lr not configured

Message d’erreur bien obscur…

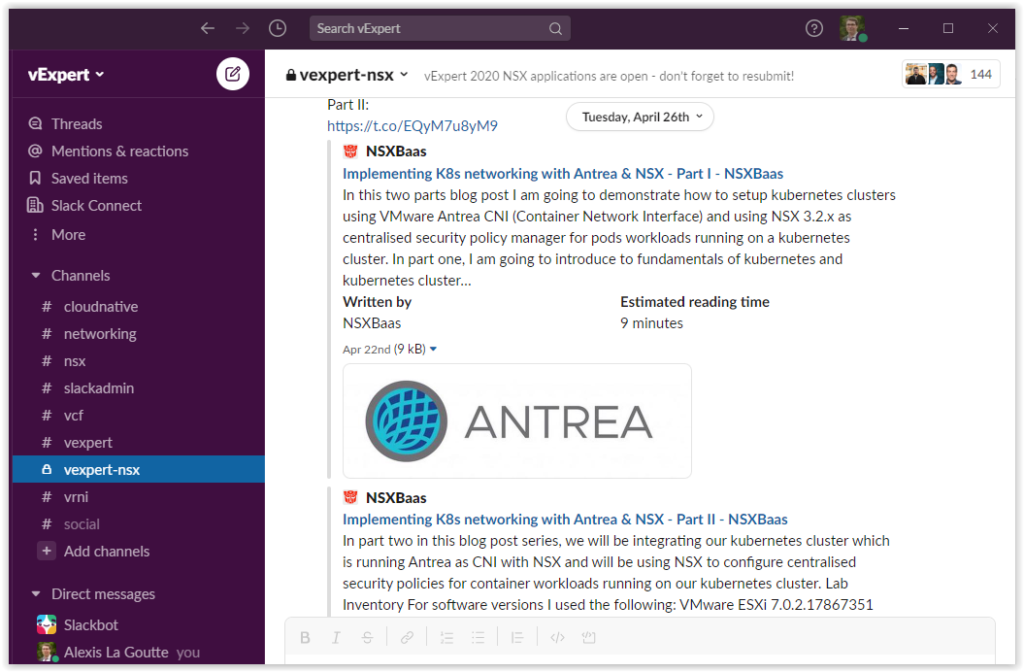

Après pas mal de recherches et une demande sur le slack vExpert !

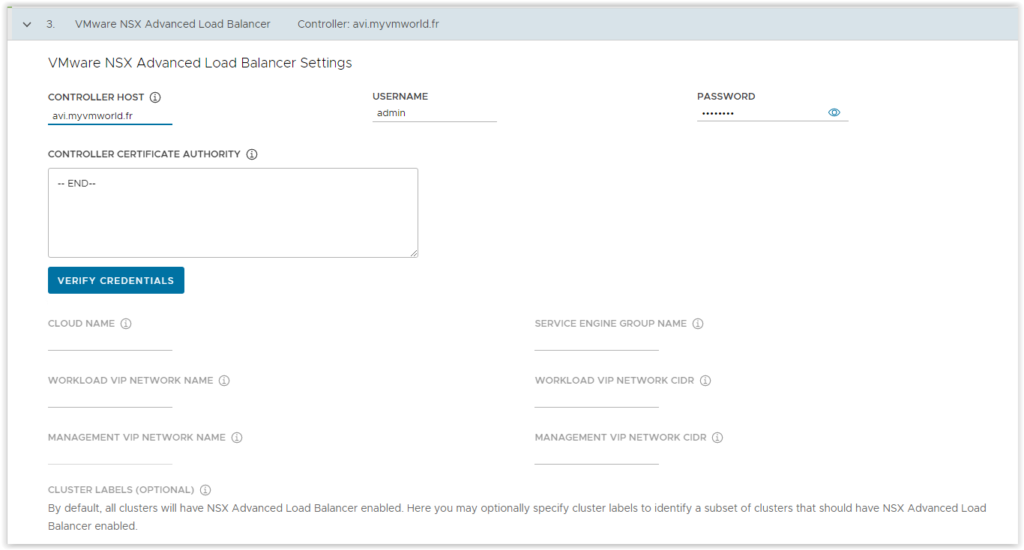

Scott m’a été d’une aide précieuse. En effet dans le Wizard UI de Tanzu.

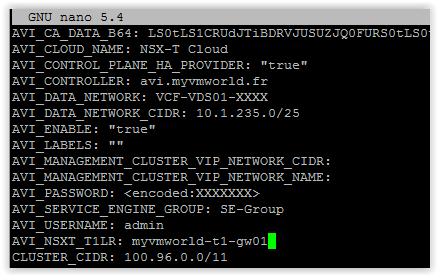

Il n’y a pas d’options pour préciser le Tier 1 de rattachement (t1_lr -> tier 1 Logical Router) ; alors que Tanzu pourrait le deviner… lors du déploiement, on lui indique bien les segments.

En faisant une petite vérification dans la documentation TKG, on trouve le paramètre (je ne sais pas pourquoi… mais le paramètre n’est pas présent dans la version pdf de la doc…)

Il suffit ainsi de rajouter au fichier de yaml de déploiement le nom du t1 et c’est reparti !

On a enfin réussi à déployer notre cluster de management (bon encore quelques adaptations auront été nécessaires… notamment concernant les ouvertures de flux vers Internet et la bonne license AVI …)

Un grand merci encore à Marie/Remy/Scott/Greg pour leur aide et leur patience