De retour de la #KUBECON #CLOUDNATIVECON Europe qui avait lieu du 19 au 22 Mars à PARIS, je souhaite vous faire un retour des infos clés, mes impressions et mes coups de cœur. Il va sans dire que cet événement acquiert une stature remarquable dans l’univers des plateformes. Attirant 13 000 participants et une multitude d’exposants, il s’impose comme un …

devOps

Cloud Adoption Framework (CAF) ?

Le Cloud Adoption Framework (CAF) est un ensemble de documents, de conseils de mise en œuvre, de meilleures pratiques et d’outils qui constituent des conseils éprouvés de Microsoft Azure, AWS, GCP, conçus pour accélérer l’adoption du Cloud. Cloud Adoption Framework Amazon Web Services Microsoft Azure Google Cloud Platform Ces services sont proposés par chaque hyperscaler, et les hyperscalers forment également …

How to Install Tanzu Kubernetes Grid in Nested Environment

Hi Everyone, It’s the first time that I write a blog post in English to touch a broad community, I hope that our French community will not be disappointed, we’ll stay the first french blog post 😀 Today I would like to talk about how to install the Tanzu environment on our PCC vLAB based on OVH. As you know …

DevOPs & Automatisation avec Dell EMC Storage

Si vous regardez ce qui motive l’automatisation aujourd’hui plus que jamais auparavant… -> la première chose c’est la mise à l’échelle, comment soutenir l’évolution de l’entreprise, et donc du sysème d’information, de la volumétrie des données,… Plus de stockage, plus de serveurs, plus d’application, besoin d’améliorer les choses… Le deuxième facteur clé est le rythme auquel les nouvelles applications et …

VMware Tanzu Community Edition : La boite à outils

Bonjour à toutes et tous, Le 4 Octobre, l’équipe Tanzu annonce la sortie de la version communautaire, « Tanzu Community Edition » https://tanzu.vmware.com/content/blog/vmware-tanzu-community-edition-announcement Et c’est une bonne nouvelle ! nous allons vous expliquer pourquoi. Pourquoi VMware sort une version communautaire? Tous simplement car Tanzu est basé sur des briques d’opensource et que les développeurs ont besoins de travailler sur Tanzu dans la …

Morpheus Data … pour rallier les plateformes Cloud – PART I

Simplifier la gouvernance et l’automatisation des clusters Kubernetes existants de fournisseurs tels que Red Hat OpenShift, VMware vSphere 7, et autres

Réduire le coût et la complexité des clouds privés VMware en combinant Morpheus avec Cloud Foundation Standard au lieu d’éditions plus coûteuses

Crossover Meetup CNCF Nantes & VMUG Nantes : un évènement unique à ne pas manquer

C’est aujourd’hui une grande première pour nos différentes communautés ! Le 19 juin 2019, nous aurons le plaisir de participer au Meetup de la Cloud Native Computing Nantes. Un grand merci aux organisateurs du Meetup Nantes (Gaëlle, Eric, Lucas, Mickaël et Vincent). Le sujet du soir: LA SÉCURITÉ AVEC KUBERNETES ET LES CONTENEURS DOCKER : UNE HISTOIRE SANS FIN… Par …

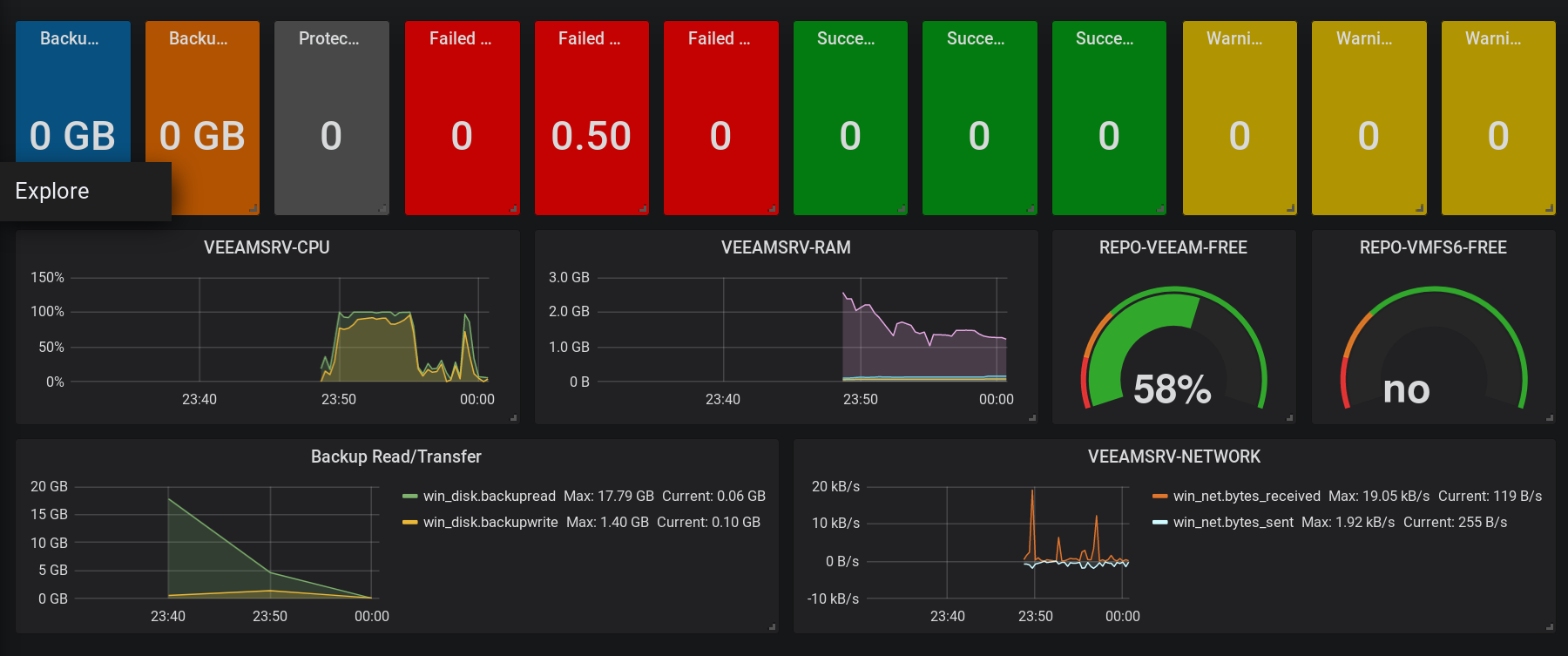

Centraliser les métriques d’une solution VEEAM grâce à Telegraf, InfluxDB et Grafana

Erwan a initié un sujet sur le triptyque Telegraf, InfluxDB et Grafana dans l’article suivant : ICI. Je vais poursuivre le sujet avec un exemple intéressant pour les « Ops » tels que moi. Nous allons décrire l’installation d’une solution de monitoring des travaux et des performances de la célèbre solution de protection de données VEEAM. Le premier réflexe à avoir lorsqu’on …

Packer, automatiser la création d’images systèmes

Il y a, dans le monde surpeuplé des outils DevOps, une société qui aujourd’hui tire son épingle du jeu en proposant des produits open source novateurs et devenus des références sur le marché. HashiCorp est une start-up fondée en 2012 par Mitchell Hashimoto et Armon Dadgar, ils se sont donnés pour but d’offrir un panel d’outils complet pour l’automatisation du …

L’admin de demain ! [ Introduction ]

Cela n’aura échappé à personne mais nous vivons une époque de profonds changements dans notre métier. De nombreuses nouvelles technologies venant bousculer nos habitudes d’Administrateur Datacenter ou étant sur le point de le faire. J’avais envie de partager avec vous ma réflexion sur le sujet. Je me rappelle régulièrement cette phrase lorsque que j’effectue une étude technique : « Nous faisons partie du …