Un retour suite à un problème rencontré lors de la mise un cluster vSAN Stretched (VCF 4.x). En VCF 4.x, on utilise maintenant vSphere 7 et donc le witness utilise aussi un ESXI en 7.0. Nous étions partis sur un witness avec 2 interfaces réseaux (un réseau dédié pour le vSAN dans une instance de routage (VRF) spécifique). Suite …

VSAN

Surveiller la capacité de stockage de son cluster vSAN 6.7

Surveiller la consommation de volumétrie de votre cluster VMware vSAN

Next VMUG – 26 Septembre 2019 – Save this date

Le VMUG (VMware User Group) de la rentrée 2019, c’est le rendez-vous annuel incontournable à ne pas manquer ! Cormac Hogan, Niels Haggort seront également présents…

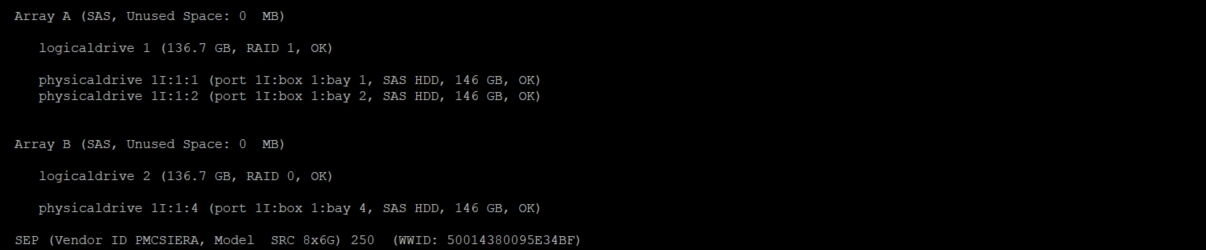

Manager une carte HPE Smart Array en CLI

Si jamais vous devez manager une carte HPE Smart Array sur un serveur proliant, sachez que vous pouvez le faire en ligne de commande grâce à l’utilitaire ssacli. Vous allez avoir la possibilité de créer des grappes RAID, les supprimer, les étendre… Bref toutes les actions courantes qu’un administrateur peut être amené à réaliser. L’outil est compatible ESXi, Windows et …

Interview Duncan & Frank au Reboot VMUG France

Interview croisée Duncan & Frank Vous l’attendiez tous depuis plusieurs jours… ! En exclusivité notre interview croisée Duncan Epping et Frank Denneman est enfin en ligne ! Revivez ou découvrez en 4 minutes chrono deux visions complémentaires de l’approche Cloud hybride de VMware qui propose une combinaison de solutions permettant aux entreprises d’étendre facilement leur infrastructure On-Premise, notamment avec les technologies …

Reboot VMUG France 2018 : big success

Reboot VMUG France Du cloud dans tous ses états, des litres de café, des speechs partenaires, des keynotes high level, des yeux plissés, des hochements de têtes, de l’expertise en basket & des applaudissements… C’est sans conteste son ambiance “friendly” qui caractérise le mieux le Reboot VMUG France qui s’est tenu il y a quelques jours dans les nouveaux locaux flambants neufs d’OVH. Technique, pointu, expert mais sans être …

VMware vExpert vSAN 2018

VMware a annoncé le 06 juin la liste des participants au programme vExpert vSAN 2018. C’est avec une certaine fierté que j’ai pu y trouver mon nom parmi les 72 nominés ! Pour rappel, ce programme tend à mettre en avant les personnes démontrant un intérêt certain pour les technologies VMware et dans ce cas précis, pour vSAN. Je ne …

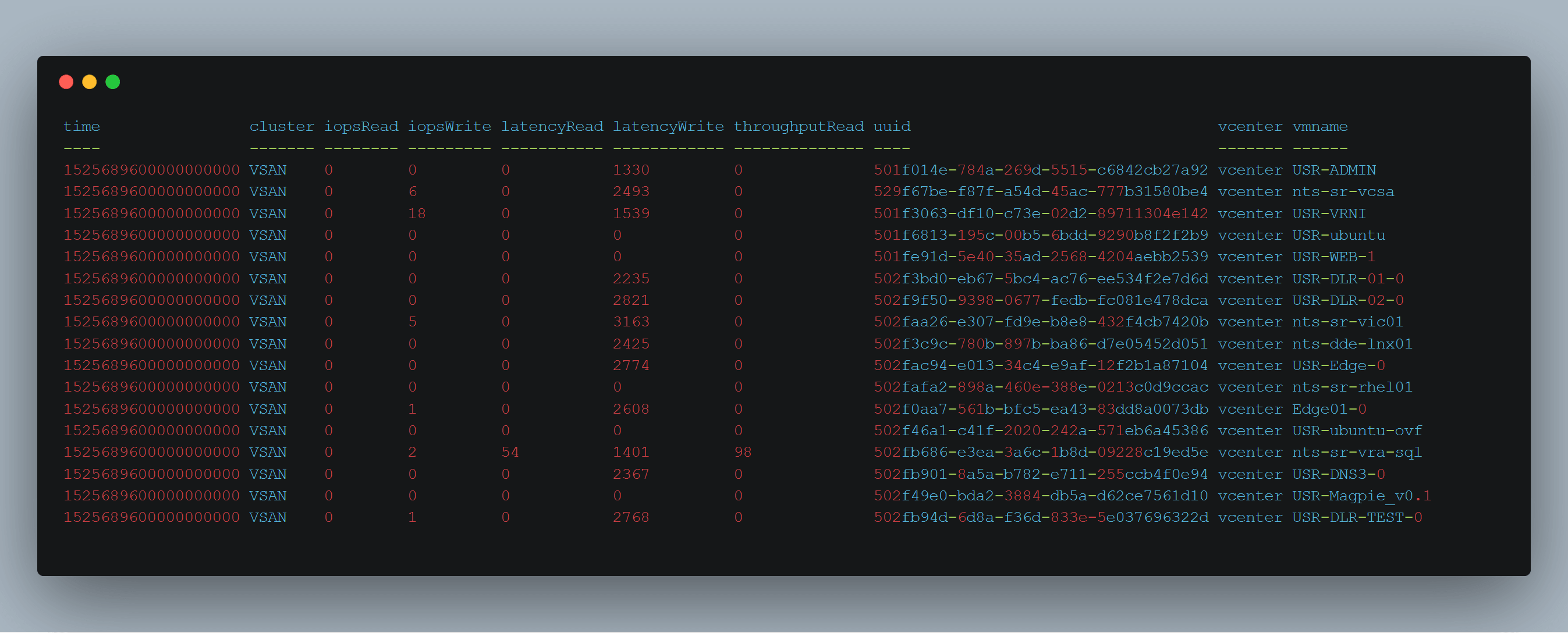

Exporter les statistiques d’un cluster vSAN avec vsanmetrics et Telegraf

Pratiquement tous les éditeurs proposent des outils de monitoring inclus dans leurs produits. Là où ca devient plus compliqué, c’est lorsque l’on souhaite centraliser ces données dans une même interface. Heureusement des outils Open Sources tels que Grafana, InfluxDB, Graphite ou Telegraf existent et vont nous permettre d’atteindre ce but (moyennant un peu d’huile de coude quand même…). Je vous …

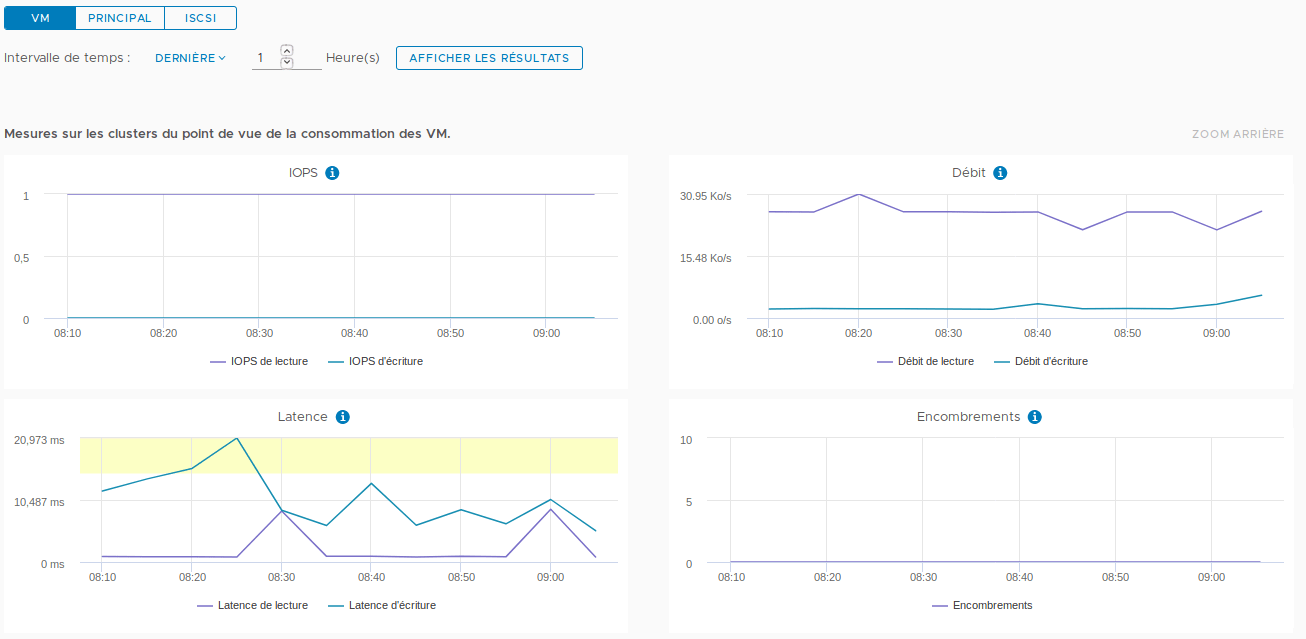

Le service de performance vSAN

Je me doute bien que vous n’allez pas dévorer cet article de la première à la dernière ligne. Je l’ai plutôt écrit dans l’idée d’en faire un document de référence pour qui souhaiterait comprendre et exploiter les statistiques disponibles pour un cluster vSAN. Vous allez y trouver des explications concernant le mode de fonctionnement du service Performance ainsi que la …

Python, vSphere, vSAN et moi

Vous le savez peut-être déjà si vous me suivez sur les réseaux sociaux, je me suis mis en tête de découvrir Python. Comme j’aime bien avoir un objectif quand j’apprends un nouveau langage, j’ai choisi d’intéragir avec des infrastructures VMware vSphere / vSAN (on ne se refait pas !). Qui dit nouveau langage, dit nouvelle façon de travailler. Entre l’installation …